随着现代技术在全球的迅猛发展,提高学生技术素养成为了各国基础教育领域的共同目标。曾经有一段时间,“技术素养”(technological literacy)一词在国外经常与“计算机素养”(computer literacy)、“信息通信技术素养”(information and communication literacy)等概念同义,但更多人认为,计算机素养、信息通信技术素养等仅仅是技术素养的一部分(Davies, 2011),技术素养的概念应该更加广泛。如Eisenberg & Johnson (2002)认为,一个具有技术素养的人能够“将技术作为一种工具加以使用,以利于组织、沟通和有关研究,并促进问题的顺利解决”;Hansen (2003)认为技术素养是“一个人通过运用、适应、创造及评价技术以使技术积极影响个体生命、社区生活及环境质量的能力”;Davies (2011)则将教育情境中的技术素养定义为“通过有效使用技术(如必要的电子工具或机械工具)来完成特定学习任务的能力”,他认为一个技术素养高的人首先能了解某些特定的技术可以满足何种需求,其次他们能熟练地运用这些技术,并深谙何种技术应该在何时被加以运用方能产生良好效果;Cook (2002)认为技术素养的内涵包括了解某种技术如何促进社会互动和社会协作, 了解使用者如何使用该技术以及如何对某种技术研究加以批判并对之改良以使之更好地被使用者所使用等;李隆盛(2000)则认为技术素养是“人类在解决实际问题以改善生活环境的前提下,善用知识、创意、机具、材料及产品等资源,以适应技术社会及在技术社会中发展的基本能力”;国际技术教育协会(ITEA, 2000)则将技术素养定义为“运用、管理、评价和理解技术产品和系统的能力”; 美国国家教育进步评估协会将技术素养定义为“一个人运用、理解和评价技术的能力,包括理解制定解决方案和达成目标所需的技术原理和策略”(NAEP, 2014a)。尽管关于技术素养这一概念的定义见仁见智,一些内涵和要素则在各种定义中共同体现,既包括“理解技术”(Davies, 2011)、“评价技术”(ITEA, 2007)、“技术态度”等内在的认知或心理品质,又包括“运用技术”“管理技术”等外在的行为能力。

从各个定义及其共同内涵可以看出,学生技术素养是多维度的。国际技术教育协会就明确指出,“技术素养的提高需要基于特定的心智能力的提升,如问题解决能力、视觉想象能力、批判性思维能力以及逻辑推理能力”(ITEA, 2007)。美国技术素养委员会则为技术素养赋予了三大维度:知识、思考与行为方式、能力(NAP, 2002)。如何有效测评学生的技术素养始终是国际社会共同关心的一大热点问题。在我国,尽管“技术素养”的概念于2003年已经正式在国家文件中出现,一些学者也对构建技术素养测评框架开展了研究(顾建军,2004;王秀红,2005;杨国海,张增常,2012;张辉蓉等,2017),但目前还未能见到比较成熟和可被大范围使用的技术素养测评工具。王秀红(2005)对技术素养的内涵进行了梳理并从“技术知识”“技术行为能力”“技术思想和方法”以及“技术情感和态度”等四个方面尝试建立技术素养的测评框架,并根据相关文献谈及了技术素养的一些主要方面,具有一定的借鉴意义,但似乎并没有考虑到全球技术素养的其他有关热点方面,如技术伦理等。张辉蓉等人(2017)试图对初中生信息技术素养的测评模型开展构建研究,该研究初步构建的技术素养测评模型虽然通过了信效度检验,但模型中仅有“信息知识”“信息技能”“互联网+思维”“信息意识”和“信息伦理”等五个较为宽泛的方面,并没有更加具有可操作性的二级指标,因而其系统性还有待完善。在国外,尽管技术素养相对于阅读素养、数学素养等也相对较新,然而一些著名的广泛应用的测评项目却早已将技术素养纳入其中来对学生进行测评,如著名的国际学生评估项目(PISA)中的科学素养测评、美国国家教育进步测评委员会(National Assessment of Educational Progress)的技术与工程素养测评,以及美国国际教育成就评估协会(International Association for the Evaluation of Educational Achievement)开发的TIMSS 2019科学素养测评项目,对相应年龄段的学生在当今时代应具备的技术素养均有所考察。因此,本文将对此类国际科学素养测评工具的框架和维度开展研究,以便为我国技术素养测评工具的深度研究与有效开发提供借鉴。

一、国际科学与技术素养测评框架及应用效果 (一) PISA科学素养测评框架虽然PISA已为我国学者和教育界所熟悉,但值得一提的是,PISA的科学素养实际分为科学和技术两个方面,这一观点可由PISA 2015科学素养测评框架报告中的一句话来印证:“本框架中科学素养的概念指的是科学知识以及以科学为基础的技术知识,虽然科学和技术在目标、过程和结果方面的确有所不同”(OECD, 2017)。在报告中,PISA将科学素养定义为“一个具有思考力的公民在与科学相关的议题以及科学理念方面的参与能力”,并将这种能力具体分为三种:科学解释现象的能力、评估和设计科学探究的能力、科学地解读数据和证据的能力(OECD, 2017)。PISA的一种理念认为,个体往往会在一种特定的环境中去展示特定的能力,而这种能力到底能发挥得如何取决于其态度和知识水平,因此PISA在制定其科学素养测评框架时并非仅将能力作为唯一的标尺,而是从情境(context)、知识(knowledge)、能力(competence)、态度(attitude)四个方面来综合测评学生的科学素养。有学者对这四个方面进行了剖析,认为能力是核心,知识是基础,态度是重要组成部分,而情境则是测评赖以发生的背景(张莉娜,2016)。在情境、知识、能力、态度的每一个维度上,则包括更为详细的测评内涵(表 1)。

| 表 1 PISA 2015科学素养测评维度 |

基于以上维度和内涵,PISA 2015测评的一个新特点在于考虑到了题目对学生的认知需求程度(cognitive demand),而非简单地以“简单”或“难”来区分。例如有些题目看似难做,但其对学生的认知要求仅仅需要足够多的回忆,学生不会做题往往是由于对与题目相关的情境不熟悉,因此难以回忆出有关意象来帮助解题,而只要能够回忆出相关情境,则此类题目就将迎刃而解,因此这一类题目虽然属于“难题”,但对学生的认知需求程度却很低。相反,有些题目所需要的基础知识看似易懂,但却需要对这些知识点进行较为复杂的推理和联系方能解答,因此这类题目属于“难题”,且对学生的认知需求程度较高。基于题目对学生的认知需求程度,PISA 2015测评框架将认知需求界定为“高度需求”“中度需求”“低度需求”三个水平来设定题目,其中“高度需求”的题目需要学生对较为复杂的信息或数据进行分析,整合与评估相关证据,根据不同的信息源来证明和推理,以及开发一个计划或一系列步骤来解决问题;“中度需求”的题目则需要学生使用和运用概念性的知识来描述或解释现象,选择两个或更多解决问题的合适步骤来组织或呈现数据,并且解读或使用简单的数据集或图形;而“低度需求”的题目则仅仅需要学生经历一种一步到位的过程,如回忆一个事实或原理,或在一张图片中定位一个信息(OECD, 2017)。

虽然PISA的直接测评对象是15岁的适龄学生,但其测评素养所体现的理念适用于整个义务教育阶段(刘帆,文雯,2015)。PISA自2000年实行测试以来,每三年举行一次。2015年共有来自72个国家和经济体的2800万名15岁学生参加了两小时的测试。PISA测试的着眼点并非局限于书本中的特定知识,而是着眼现实和未来生活中的各类实际挑战,不仅考察学生的知识和技能,亦考察学生的动机、兴趣、态度等隐性素养。这一点是PISA测试与我国当前基于课业内容的学业成绩评价方式或选拔考试最大的不同。该测评体系基于一定的常模,旨在开展国际性比较评价,从而为各参与国家或经济体制定或调整相关教育政策提供参考。

(二) 美国NAEP技术与工程素养测评框架作为美国基础教育领域最具影响力的评估项目,美国国家教育进步测评项目(NAEP)多年来持续定期对四年级、八年级和十二年级学生的写作、数学、历史、阅读、公民学、科学以及地理等科目进行测评,以了解其学业动态。2014年NAEP首次针对适龄学生的技术素养与工程素养进行了评估,测评完全通过网络进行,其目的是进一步为改善STEM教育提供有力的改革证据。

测评框架主要考察学生在“技术与社会”“设计与系统”以及“信息与通信技术”等三大领域(area)中关于“理解技术原理”“问题解决与目标达成”以及“沟通与合作”三方面的实践能力(practice)(NAEP, 2014b)。值得说明的是,这三大领域和三种实践能力并不存在一一对应的关系,而是互相重叠互相渗透,任何一个领域都可能体现出任何一种实践能力,三种实践能力也贯穿于三个领域。而三大领域各有不同侧重的子领域来测评学生的技术素养,如“技术与社会”领域的子领域包括“技术和人类的相互作用”“技术对自然界的作用”“技术对信息和知识的影响”“运用技术的伦理、公平和责任”。

与PISA测试一样,NAEP技术与工程素养测评框架也注意到了领域和实践能力的测评都必须基于一定情境(context)的事实,即学生需要被置于一定的真实情境中去解决问题,因此NAEP也将情境作为一个维度,与领域和实践能力一起构成了测评框架的三维度,如表 2所示。

| 表 2 NAEP 2014技术与工程素养测评维度 |

NAEP技术与工程素养测评框架并非白手起家,而是参考了现有的各种相关标准,如《21世纪学习技能框架》《技术素养标准:技术学习之内容》以及各州已有的技术教育标准等(赵中建,2016)。在此基础上,NAEP大胆创新,使其大量的题目基于一定的场景(scenario-based task)而呈现,而场景则由电脑文本、视频、动画或图表等多种形式加以表现,通过故事线的方式逐步展开要完成的任务(杨玉琴,2017)。除场景题目外,测评也会出一些独立性的选择题或建构反应题(constructed response item),即简答题,以减少题目对同一场景的依赖性从而保证测量信度。其中建构反应题又分为短建构反应题目(short constructed response item)和长建构反应题目(extended constructed response item)两类,前者要求学生就相关问题给出正确的词、数量关系等简短的阐释,而后者则要求学生就特定问题或场景给出尽可能多的反应,从而作为证据来判断学生是否以及多大程度上拥有了相关领域的实践能力。

NAEP测评在美国分为全国性测评和州测评两种,全国测评每年实施一次,州测评则两年一次,均在当年一月的最后一周至三月的第一周进行。作为美国长期性的全国评价体系,NAEP由联邦政府主导实施,并由法律制度加以保障。值得一提的是,虽然NAEP在美国已具有40余年的历史,但其对技术和工程素养的测评在2014年则属首次开展(赵中建,2016)。2014年,全美共有来自840个学校的约21500名八年级学生参加了工程与技术素养测评(NAEP, 2014b)。

(三) TIMSS 2019科学素养测评TIMSS的全称为国际数学与科学研究趋势测评(Trend in International Mathematics and Science Study),TIMSS 2019测评框架由国际教育成就评价协会(IEA)于2017年9月正式发布,测评对象为四年级和八年级的适龄学生。TIMSS 2019科学素养测评框架主要包括内容(content)和认知(cognitive)两大领域。在内容领域,四年级的测评内容包括生命科学、物质科学和地球科学,其中生命科学内容所占比例最高;八年级的测评内容包括生物、物理、化学和地球科学四个科目。而认知领域则主要考察学生“知道”“应用”和“推理”等三方面的认知素养。此外,TIMSS 2019科学素养测评框架还将“科学实践”作为一大维度加以测评,主要从“基于观察提出问题”“获取证据”“使用数据”“回答研究问题”及“基于证据提出论点”等方面考察学生的科学素养。具体各维度详见表 3。“聚焦课程”是TIMSS测评相比于其他测评工具的一个特点(Cresswell, Schwantner, & Waters, 2015.p.50),TIMSS科学素养测评框架中的“内容领域”与各国基础教育的课程设置基本吻合。而“认知领域”则是对布鲁姆关于教育目标分类学的实际应用,同时TIMSS 2019新增加的“科学实践”维度亦弥补了此前对于科学探究过程关注的不足。

| 表 3 TIMSS 2019科学素养测评维度 |

TIMSS测试自1995年首次举行以来,每四年举办一次,通常在美国本土举办。但1995、2008和2015三年的测试包括了世界其他国家和地区的参赛学生。基于网络开展测评是TIMSS 2019的新尝试。借助网络平台,TIMSS 2019相比于先前的试题则更富有创新性、实景模拟性以及问题导向性。

二、国际科学与技术素养测评框架设计理念及方法虽然PISA、NAEP和TIMSS测试的对象不尽相同,PISA测试对象主要为15岁的各国适龄学生,NAEP主要在美国本土使用,TIMSS主测对象为四年级和八年级的学生,但纵观这三大国际知名的科学与技术素养的测评框架,可以发现它们具有一定的共性。

(一) 测评框架均同时体现经典测试理论和项目反应理论通过对三大国际科学与技术素养测评的分析可以看出,三大测评框架中并存经典测试理论(CTT)和项目反应理论(IRT)。所谓经典测试理论又称为真分数理论(True Score Theory),指任何测量皆由两部分组成,一部分称为真分数部分,代表被试者在能力、知识、个性等所测特质上的真实值,另一部分为误差部分,两者相加构成一个实得分数。经典测试理论因其数学模型简单且容易计算而较易推广。标准化测试是经典测试理论最为广泛的应用,多数情况下经典测试理论凭其完整易行的项目分析方法可以放心地应用。然而经典测试理论基于的假设,即真分数与观测分数间存在线性关系,并不符合一般性事实。事实上,两者之间往往以非线性关系为主。同时,经典测试理论要求所选取的样本必须具有代表性,否则所求得的各项结果则均不真实(杜洪飞,2006),这也使得经典测试理论具有不可忽视的局限性。

项目反应理论又称项目特征曲线理论,其考察对象聚焦于被试者的能力。虽然经典测试理论和项目反应理论的数学模型都着眼于将可观察到的被试的反应和无法观察到的被试的潜在特质相联系,但正如前面所说,经典测试理论将这种联系建立在一种线性关系上,而项目反应理论则对这种联系采用非线性概率模型进行处理,从而能更好地反映被试者的真实心理情境。相比于经典测试理论,根据项目反应理论编制的题目往往具有较高的效度和信度。

PISA,NAEP及TIMSS中的传统题目仍对传统测试理论有所体现,但更多的情境性题目则对项目反应理论有更为明显的体现。事实上,由于现代素养测评中对复杂任务的测量需要对学生在一系列任务中的行为模式进行分析,因此采用项目反应理论中以概率为基础的测量理念更为适合。除PISA、NAEP及TIMSS外,许多其他的国际大型测评项目也纷纷都采纳了项目反应理论来进行评分,如PIRLS(Progress in International Reading Literacy Study)、PIAAC(Progress for the International Assessment of Adult Competencies),STEP(Skills Toward Employment and Productivity)等(Cresswell, Schwantner, & Waters, 2015)。

(二) 测评框架基于情境而设计依据特定的社会情境来设题是越来越多的素养测评框架采用的理念,这一理念在PISA、NAEP和TIMSS中均有明显体现。此类情境往往围绕解决一个现实问题而设定,如PISA 2015年的测试题目中以学生们熟悉的豆浆机为背景考察了电能、电费和热能的计算(胡圆圆,2017),NAEP要求学生以工程师的角色来解决偏远山区供水方面的故障问题(NAEP, 2015),而TIMSS则以乡村居民想砍树做木材为情境,考察学生对植物和环境作用的理解并进行决策的能力(梁润婵,2009)。据统计,在历年三种国际素养测评框架中,PISA关于生活情境的题目最多,占公布题目总数的92.2%,NAEP和TIMSS生活情境题目的比例则分别为41.4%和42.4%(梁润婵,2009)。因此,我国在设计技术素养测评框架时应以综合性的现实问题创设学习情境。

(三) 脚本型题目与传统题目相辅相成从三大国际素养测评框架来看,一方面传统的独立型题目依旧被广泛采用,另一方面专门针对技术素养特点的脚本型题目也被大量应用。传统的独立型题目往往会向考生提出一个特定的问题并提供有关支持性信息,作答方式既可以是选择正确答案也可以是进行简要陈述。题目之间彼此独立,没有相互关联。例如学生会看到一幅正在开花的植物图片,并被询问“开花的目的是什么”,学生可在四个选项中加以选择。

而脚本型题目的特点主要体现在情境与任务设计、工具箱设计和人机互动等方面。脚本型题目会为测评任务呈现一个具体的情境,在情境中引出学生需要完成的任务。该任务尽可能与现实社会贴近,可能发生在校内或校外。在给定的脚本情境中,题目会给出一个具有激励作用的总目标,这个目标可能是解决一个具体的难题,也可能是实现一个特定的目标。一种具体的脚本会呈现一个系统,如一个灌溉系统或一座水坝,该系统由彼此相关的元素构成,于是学生可以观察某个元素在整个系统中的作用和功能(如当灌溉系统的阀门打开时,观察会发生哪些现象),或与某个元素进行互动(如给系统中某个变量赋一个具体的值)以观察元素的变化对整个系统的影响。有些脚本型题目也会设定一个全局性的目标,或是一个需要完成多种任务才能解决的问题。例如题目的总目标是策划一台戏剧,并指定戏剧内容属于某个特定历史时期。该题目可能涉及以下几个任务:检索信息以找到该历史时期的一个著名事件, 为实现收支平衡而计算需要卖出多少张票,以及制作一张宣传海报。

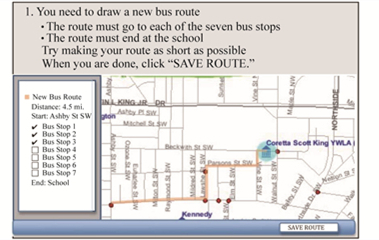

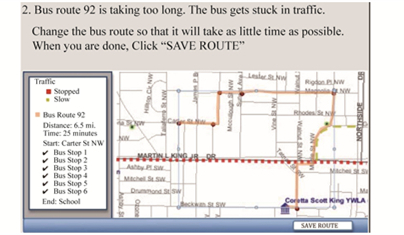

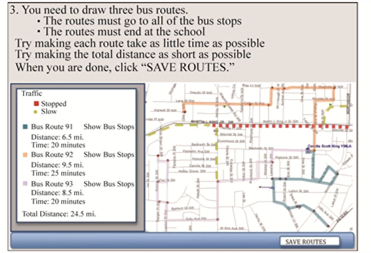

表 4以及图 1至图 3(WestEd, 2011, pp.4-17)共同展示了一个脚本型题目的实例,从实例中可以看出,开发脚本型题目,首先要设计一个脚本的概要,概要包括考生的年级水平、考察的内容领域、认知领域以及具体的考察目标、需要考生完成的任务以及所处的情境、可用来完成任务的资源和信息、可用的工具等(表 4)。而图 1、2、3则依次展示了这道脚本型题目中的三个具体任务。例如第一个任务是让考生使用地图设计校车路线,路线要涵盖所有七个车站且使终点为学校,并且路线的总里程越短越好。第二个任务的背景则是92路公交的路线太长且经常堵车,任务要求考生调整路线以使总行程耗时最短。第三个任务则让考生分别为三路公交设计路线,要求包含所有车站且终点都是学校,同时每条路线耗时尽可能少,并且三条路线的总里程尽可能短。可以看出,三个任务的难度呈递增趋势,最初的任务只需考虑系统中的个别元素,随后则需要考虑元素之间的相互影响,最终则要全盘考虑整个系统。

| 表 4 脚本型题目的脚本范例 |

|

图 1 脚本型题目的分任务一 |

|

图 2 脚本型题目的分任务二 |

|

图 3 脚本型题目的分任务三 |

脚本型题目和传统题目的并用一方面有利于利用场景考察学生知识迁移能力,另一方面也可以避免测评对同一场景的过度依赖。

脚本型题目的呈现需要借助现代科技手段加以支撑,计算机具有动态支持视频、动画、文本、图表等各类脚本的作用,而这一功效是静态纸质版题目所无法比拟的。如通过与计算机系统所呈现任务中的关键元素进行互动,学生可以对题目要求的任务做出反应。学生可在控制某些变量的同时,操作另一些变量,观察系统由此发生的变化; 或是通过观察和描述某些变量的特征及规律,来解释来自系统的反馈,评估出现的结果,由此形成结论。这一方式使得测评人可以通过跟踪学生与计算机系统的互动过程来判断学生的技能掌握水平。

(四) 素养测评基于计算机开展日益成为趋势例如一道关于草坪喷洒系统的题目要求学生找出喷洒系统发生故障的原因,学生为了找到原因需要操作系统的多个要素,这种操作行为与操作过程即可直接反映学生的技能水平。测评系统会记录学生操作了哪些要素与工具、如何操作、操作的用时,并判断学生的操作究竟是随机操作还是依据一定的认知逻辑等。对人机互动过程的跟踪,至少可以为三种测评目标提供证据。第一是对行为模式的评价,例如通过观察学生一系列行为的顺序,判断学生是否采取了恰当的行动以及是否以最优化的顺序完成一组行动。第二是对操作行为的评价,例如判断学生如何调整系统中某个重要部件,如何实现数据所呈现形式的变化等。第三是对交流与合作技能的评价,例如通过记录学生与计算机虚拟团队成员的交流次数来判断学生小组合作策略的有效性。

(五) 对内容性知识、程序性知识和认知性知识的并重考察PISA测评框架中对认知需求程度(cognitive demand)的引入充分说明科学与技术教育必须要超越对静态内容性知识的传输和记忆,而致力于培养学生在真实情境中把握一定的程序且基于高阶思维来解决实际问题的能力。PISA测试从2000年笼统的“科学知识”细化为2015年的“内容性知识、程序性知识、认知性知识”,体现了世界科学教育改革进程的趋势(刘帆,文雯,2015)。事实上,程序性知识往往直接对应着“怎么做”的方面,体现着人们俗话所说的“学习能力”。而认知性知识则相当于一种元知识,它可以考察学生对某个知识本身及应用的全面理解和掌握。因此,在设计技术素养的测评框架时应同时并重对内容性知识、程序性知识及认知性知识的考察,以测评学生高阶思维的实际发展水平。

三、我国中小学生技术素养测评工具的设计与使用 (一) 测评工具的设计21世纪初,南京师范大学技术教育研究所顾建军教授团队就开始进行了我国中小学生技术素养测评工具的设计尝试(王秀红,2005)。2007年,该团队承担了教育部重点课题“以技术素养为目标的我国中小学技术教育体系建构研究”,对我国中小学生技术素养测评工具进行了一定的理论与实践研究,并在全国10个省市区进行了调查研究。2012年,其承担的教育部人文社会科学项目“现代化进程中我国国民技术素养现状及培养策略研究”,进行了我国公众技术素养测评工具的研制,样本覆盖全国所有省市区。2016年,以顾建军教授为组长的普通高中通用技术课程标准修订组还进行了高中学生基于技术学科的核心素养测评工具的研制,并采用纸笔测试、项目实践测试等方式在全国6省市进行了抽样测试。这为立足中国国情的中小学生技术素养测评工具的进一步研究奠定了理论与实践基础。

受国际科学与技术素养测评框架的启发,本文拟从测评情境、测评领域、测评目标和试题开发等维度阐述面向我国基础教育阶段的技术素养测评框架的设计,测量框架可以根据不同对象不同年龄阶段加以调整(见表 5)。

| 表 5 技术素养测评框架 |

测评情境以基于学生的经验与生活、面向真实的技术世界为理念。技术是人类从真实的需求出发的,也都运用于真实的生产、生活情境,解决着实际的生活问题。基于这一理念,题目从真实的技术需求、真实的技术过程出发设计情境,避免脱离实际、不符合科学的情境,以及学生无法经历和体验的情境。测评情境包括“技术与世界”“技术与国家”“技术与社会”“技术与人”“技术与自然”“技术的性质”等六大情境,每一种情境均与学生的生活及所见所闻息息相关,旨在将学生置于认知熟悉且领域广泛的不同情境中去辨析技术的价值与运用。该测评情境既吸收了PISA科学素养框架中的“个人情境/本地或本国情境/全球情境”,又吸纳了NAEP技术素养框架中对各类社会议题的关注,同时关注我国中小学生对技术与人、与社会等复杂关系的理解,关注人类技术如何与自然和谐共处以及未来发展趋势的判断能力,是技术素养综合维度的重要组成部分。情境考虑到现有我国中小学技术类课程设置及实施的现状和学生已有的技术领域的知识与经验以及时代发展的技术特征,既能保证题目有具体可参的科学来源,又能保证它与学生的生活紧密贴合,有利于学生的理解与思考。

测评领域以“四元论”的技术素养结构为理论模型, 包括“技术知识” “技术能力”“技术思维与行为方式”以及“技术情感与态度”等四大部分。“知识”“能力”及“态度”是三大国际测评工具共同考察的维度,也是所有学生提高技术素养的基石。需要说明的是,“技术知识”部分包括技术本体的知识(如技术的构成、技术的性质等)、技术历史的知识和技术类别的知识,其中技术类别的知识目前主要采用国际技术与工程教育协会(ITEEA)的医疗技术、农业及相关生物技术、能源与动力技术、信息与通信技术、交通运输技术、加工制造技术、建筑技术等领域的知识,同时兼顾内容性知识、程序性知识以及认知性知识。“技术思维与行为方式”则旨在对技术的意识(如技术的规范意识、安全意识、质量意识、经济意识、劳动意识、人技关系认识等)、技术的思维(包括工具思维、系统思维、权衡思维、优化思维、可靠性思维等),及有关技术伦理道德行为等重要方面的考察。这一创新点还针对我国当前中小学教育重理论轻实践、重做题轻操作的现实困境,主要考察学生是否有意识地运用一定的技术思想方法主动使用某项技术(或工具)来解决特定的现实问题。而技术伦理则是各国技术与工程界日益关注的重要维度,其本质属于一种技术运用的思维及行为方式。在当前诸如环境污染、气候变暖等由科技进步引发的全球性挑战背景下,我国也应当顺势而为,在中小学阶段就培养学生的技术理性和伦理观念,从而为学生在未来生活中负责任地使用技术奠定坚实基础。

测评目标和试题开发以“中度需求”水平为基准,结合具体的测评领域,参照现有的国家和地方相关标准根据中小学生阶段技术素养培养的基本目标和要求来确定。如表 5所示,每一个测评方面都包括更加具体的测评目标的描述。比如在技术知识领域,设计的题目要兼顾内容性知识、程序性知识、认知性知识,内容性知识旨在考察学生是否了解特定技术的应用场合、历史价值及与其他科学或技术的关联性等,程序性知识则旨在考察学生是否了解特定技术(或工具)的操作或工作步骤,认知性知识则在于考察学生对特定技术(或工具)的一般性非底层工作原理的了解等。

基于以上拟定设计的素养框架,有关机构和部门应聘请专业的开发团队,精心为每个测评领域设计题库,同时研发支持该类技术素养测评的计算机辅助系统,探索测评理念的计算机化。

(二) 测评工具的初步使用为了验证以上素养框架使用的有效性,南京师范大学技术教育研究所初步开发了面向我国初中阶段和小学阶段的技术素养试卷各一份,并于2018年6月至7月在我国8个省(含自治区)的共20所学校进行了测试。值得说明的是,鉴于当前我国一些小学的现实条件并不允许所有学生在校期间能够配备人手一台计算机及其他学习的电子设备,且许多学校明确出台政策不允许学生将电子设备带入校园使用,因此这一阶段的试测尚未基于网络平台,而是基于纸质版试题加以开展。

两份素养试题结构一致,除获取学生关于性别、年级、父母职业、职业理想等基本信息外,素养试题的核心包括“技术知识”“技术能力”“技术思维与行为方式”“技术情感与态度”等四个方面。其中“技术知识”“技术能力”“技术思维与行为方式”等三方面维度以选择题的形式呈现给学生,“技术情感与态度”部分则依据5级李克特等级量表考察学生对有关技术态度的强烈程度。选择题的形式有助于深度考察学生关于某些特定技术知识的具体认知和思维方式,在获取学生作答试卷之后,研究团队对学生每一道题的作答正误情况均会赋值(作答正确赋“1”,作答错误赋“0”),而学生在“技术情感与态度”部分基于李克特量表的回答则被相应赋值(1表示某方面程度最深的A选项,5代表程度最浅的E选项),从而为进一步测试试题的信效度奠定基础。

| 表 6 南京师范大学技术素养测评框架题例 |

该次测试共发出试卷2996份,回收2610份,回收率为87.11%。剔除无效作答的试卷后,共包括有效试卷2431份,其中初中组有效试卷1167份,小学组有效试卷1264份。试题各维度的内部一致性信度主要由Cronbach α系数加以检验。中、小学技术素养问卷的“技术知识”“技术能力”“技术情感与态度”三大维度的信度均在0.7左右,说明已达到可供分析的水平,而“技术思维与行为方式”维度的信度还有一定的提高空间,这也说明技术思维与行为方式的复杂性和成熟测评工具开发的艰巨性。而效度则可通过分析问卷总分与各维度总分之间的Pearson相关性加以验证。中、小学技术素养试卷的技术知识部分、技术能力部分均与总分显著相关,并达到较高水平。(具体数据可参阅本期刊发的张沿沿等人的文章《对我国8省市区义务教育阶段学生技术素养的调查与研究》)

该次测试在编制问卷具体题目时,还在所述技术素养测试框架下,参考了我国最新发布的国家科学课程标准、综合实践活动课程指导纲要和部分省市区九年义务教育阶段信息技术、劳动与技术课程纲要中对学习目标的阐述和对学习内容的阐述,在切合学习目标的基础上,借鉴有关教材文本内容来设计题目的具体情境与问题,既体现了该次调查与测评工具框架的一致性,也保证了题目来源的可靠性。通过该次我国8个省(含自治区)九年义务教育阶段共20所学校学生技术素养的调查工具的多方面检验和调查结果的多方面分析,初步体现出测评工具框架视野的开阔性、领域和目标的时代性以及对我国基础教育学生的适切性。当然,该次测试也反映了测评工具框架在目标的进一步细化、在“技术能力”“技术思维与行为方式”维度测评目标的进一步结构化和优化等方面也有一定的深化研究的空间。

总体而言,本研究基于多个国际科学与技术素养测评的共性要素,尝试设计了较为适合我国中小学阶段使用的技术素养测评框架,并通过较大样本量的测试初步验证了面向初中和小学两个基础教育阶段技术素养测评工具的信度和效度。

| 杜洪飞. (2006). 经典测量理论与项目反应理论的比较研究. 社会心理科学, 21(6), 15-17. |

| 顾建军. (2004). 世界各国技术类课程的设置启示. 世界教育信息, (5), 49-53. |

| 胡圆圆. (2017). PISA 2015框架下科学习题质量分析与改进策略.宁波大学硕士专业学位论文. |

| 李隆盛. (2000). 科技与人力教育的提升.台北: 师大书苑. |

| 梁润婵. (2009). TIMSS、PISA、NAEP科学测试框架与测试题目的比较研究.广西师范大学硕士专业学位论文. http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=D070032 |

| 刘帆, 文雯. (2015). PISA2015科学素养测评框架新动向及其对我国科学教育的启示. 外国教育研究, 304(42), 117-128. |

| 王秀红.(2005).普通高中学生技术素养现状调查及教育对策研究.南京师范大学硕士学位论文. http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=Y801164 |

| 杨国海, 张增常. (2012). 技术素养的内涵及测评框架. 湖北民族学院学报(哲学社会科学版), 30(2), 149-152. |

| 杨玉琴. (2017). 美国NAEP技术与工程素养评估述评. 外国教育研究, 44(8), 22-35. |

| 张辉蓉, 杨欣, 李美仪, 李思睿, 宋宇轩. (2017). 初中生信息技术素养测评模型构建研究. 中国电化教育, 368(9), 33-38. DOI:10.3969/j.issn.1006-9860.2017.09.006 |

| 张莉娜. (2016). PISA 2015科学素养测评对我国中小学科学教学与评价的启示. 全球教育展望, 45(3), 15-24. |

| 赵中建. (2016). 美国中小学工程教育及技术与工程素养评估. 全球教育展望, 45(12), 3-24. |

| Cook K.C. (2002). Layered Literacies:A Theoretical Frame for Technical Communication Pedagogy. Technical Communication Quarterly, 11(1), 5-29. DOI:10.1207/s15427625tcq1101_1 |

| Cresswell, J., Schwantner, U., & Waters, C. (2015). A review of international large-scale assessment in education: Assessing component skills and collecting contextual data. Paris: OECD Publishing. |

| Davies R. S. (2011). Understanding Technology Literacy:A Framework for Evaluating Educational Technology Integration. TechTrends, 55(5), 45-52. DOI:10.1007/s11528-011-0527-3 |

| Eisenberg, M.B., & Johnson, D. (2002). Learning and teaching information technology: Computer skills in context. ERIC Document Reproduction No. ED 465377. |

| Hansen J. W. (2003). To change perceptions of technology programs. Journal of Technology Studies, 29, 16-19. |

| IEA. (2017). Timss 2019 frameworks. MA: TIMSS & PIRLS. |

| ITEA (International Technology Education Association). (2000). Standards for technological literacy: content for the study of technology. Reston, Va: ITEA. |

| NAEP (National Assessment of Educational Progress). (2014a). Abridged technology and engineering literacy framework. Retrieved from: http://iucat.iu.edu/iupui/13455870. |

| NAEP (National Assessment of Educational Progress). (2014b). About the TEL Assessment. Retrieved from: https://www.nationsreportcard.gov/tel_2014/#about/overview. |

| NAEP. (2015).Explore a TEL task. Retrieved from: http://nces.ed.gov/nationsreportcard/tel/wells_item.aspx. |

| NAP (National Academies Press). (2002).Technically Speaking: Why All Americans Need to Know More About Technology. Washington, D.C. |

| OECD. (2017). PISA 2015 assessment and analysis framework: Science, reading, mathematics, financial literacy and collaborative problem solving (revised edition). Paris: OECD Publishing. |

| WestEd.(2011).Technology and engineering literacy assessment and item specifications for the 2014 National Assessment of Educational Progress (pre-publication edition). Retrieve from: http://www.nagb.rog/publications/frameworks/technology/2014-technology-framework. |